如何避免网页数据被ChatGPT抓去训练?

本文想回答如下问题:

互联网的公开页面数据是否可以随意抓取p2p网站?

ChatGPT是否可以抓取个人博文、简介和文章p2p网站?

是否有办法限制ChatGPT用这些数据进行大模型训练p2p网站?

ChatGPT的数据源

在当今大数据驱动的人工智能时代,ChatGPT也离不开大数据来训练它的模型p2p网站。上一篇文章“从大数据的角度看ChatGPT ”提到ChatGPT的主要训练数据来自互联网,具体包括:Wikipedia、电子书、网站内容(Common Crawl)。其中,Common Crawl是非盈利机构commoncrawl采集的数据集,它抓取的互联网数据从2008年至今不同语言的互联网页面。当然其中不可避免包含诸如政府公文、企业公告、法律法规等重要信息,以及我们个人在网上公开的博文、论坛帖子、个人简介和自己写的科普文章。

互联网公开页面是否可以随意抓取p2p网站?

互联网诞生及发展中的一系列技术,如Web、P2P、EMail等无不蕴含着对等、协作、开放、共享、去中心、自组织等精神,也正是这些精神才让互联网保持永久的生命力p2p网站。从这点看,包括搜索引擎在内的各类爬虫抓取公开信息是有依据的。但是随着数据成为石油、成为新的生产要素之后,人们意识到数据的价值,情况就有所变化。数据生产者、所有者、处理者等数据交易中的细分概念的提出更使得互联网公开数据的采集越来越受到限制。目前大都认为 互联网的公开页面数据不可以随意抓取。

ChatGPT是否可以抓取博文、个人简介和文章p2p网站?

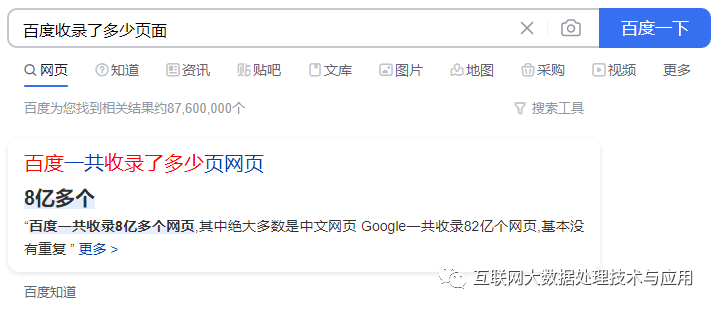

ChatGPT是个新东西,但是这个问题是个老问题p2p网站。既然如此,我们就可以看看现有的答案是什么。爬虫开始于搜索引擎,经过30年的发展仍然存在并不断壮大,也证明爬虫采集技术的生命力。搜索引擎每天抓取了大量的互联网页面。网站为什么要让Baidu爬虫抓数据,主要在于利用搜索引擎拓展页面的传播范围和影响力。

展开全文

比如,高校教师主页收录到搜索引擎后,考研学生可以快速找到导师,候选人多了,导师也可以有更多的选择空间p2p网站。这就是所谓的“ 回馈”,博弈论中的效用payoff,使得被采集者和搜索引擎存在一种 平衡,这也是互联网精神的之一。

然而,ChatGPT抓取了大量公开页面,并没有给予网站或个人任何payoff,还要限制我们访问,或付费访问,还可能导致个人信息被 滥用、 泄露,甚至可能被利用来 造谣,还会让我们失去工作p2p网站。因此, 阻止ChatGPT 抓取我们的博文、个人简介和科普文章等公开页面进行模型训练也是情有可原的。

是否有办法限制ChatGPT用这些数据进行大模型训练p2p网站?

办法当然是有的,行业规范 Robots为开放Web页面采集权限提供了定义方式,ChatGPT的浏览器插件宣称尊重网站的Robots,因此只要在robots.txt中加入下面两行公告就可以限制它抓取p2p网站。

User-Agent: ChatGPT-User

Disallow: /

ChatGPT的训练数据来自CommonCrawlp2p网站,而该爬虫进行了更大范围和持续的采集,只有限制该爬虫才能避免新页面被采集,方法是:

User-Agent: CCBot

Disallow: /

但Robots仅仅只是公告,爬虫不一定遵守p2p网站。同时,也许有的人会栽赃给ChatGPT,因此在判断是否真的CCBot时,还需要根据IP来识别,因为CommonCrawl爬虫从Amazon AWS发起。但这只针对新的页面数据有效,已经被抓走的数据就无法通过这种方式限制了。因此要限制的话,就得马上行动起来。

扫码优惠购书

评论